Google Just Put AI Inside Gmail: Three Billion Inboxes Are About to Change.

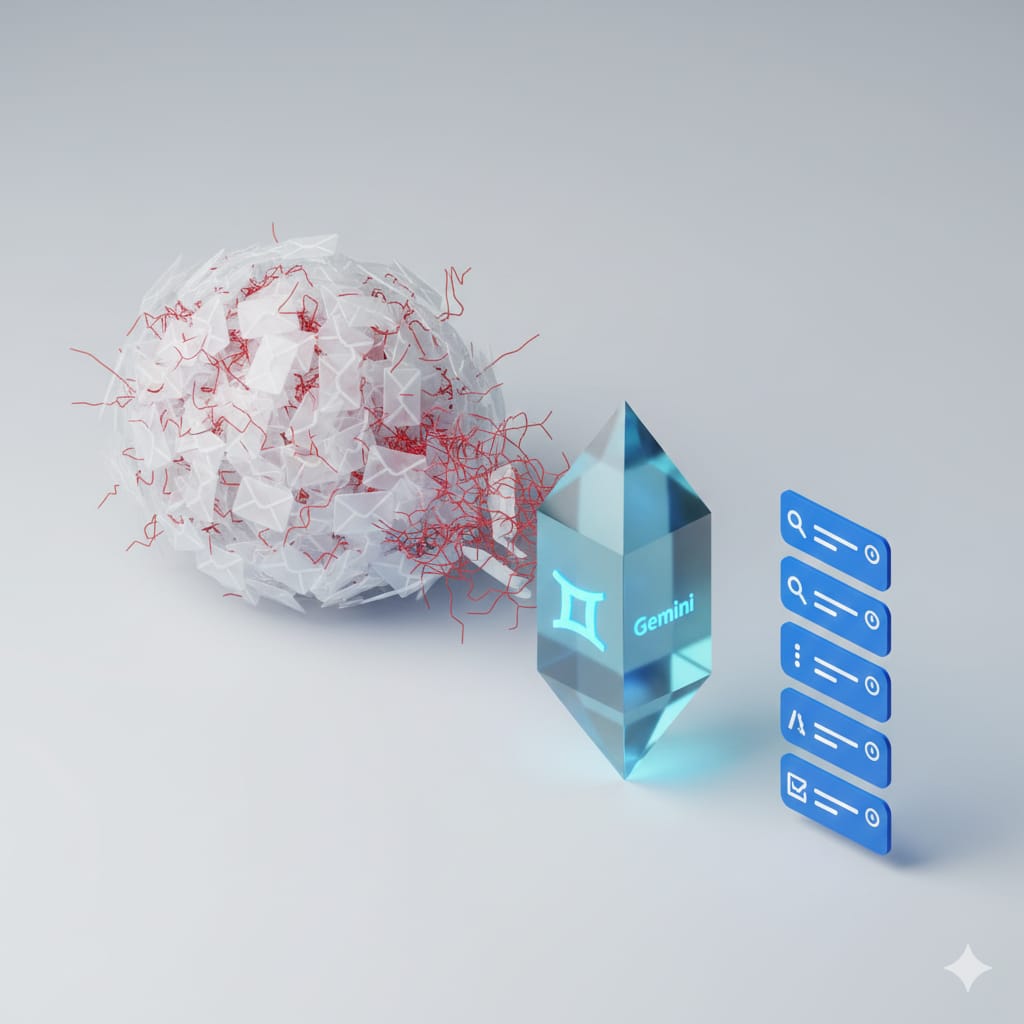

Google has officially embedded AI into Gmail, and this is not just another productivity update. Email is one of the most cognitively demanding systems people use daily, and now AI is sitting directly inside it. With Gemini, users can summarise long email threads instantly, ask their inbox questions in plain English, write or polish emails for free, receive reply suggestions that actually sound like them, and check tone, grammar, and clarity. Soon, Gmail will also auto-filter clutter, flag VIP messages, and surface high-stakes emails. The rollout starts in U.S. English, with more languages coming, and some advanced features requiring Pro or Ultra plans. From a therapy perspective, this shift matters more than it appears. Email is not just communication. It is executive functioning in action. It requires planning, prioritisation, working memory, emotional regulation, and pragmatic language skills. For many clients, and many clinicians, email is a daily source of cognitive overload. What Gemini is doing is externalising parts of that cognitive load. Summarising threads reduces working memory demands. Asking the inbox questions bypasses inefficient search strategies. Tone and clarity checks support pragmatic language. Drafting assistance lowers initiation barriers. These functions closely mirror the supports we already use in therapy, making Gemini function like a cognitive scaffold rather than a replacement for thinking. So how might therapists actually benefit from this? For speech and language therapists, Gemini can support professional written communication without compromising clinical intent. Writing parent emails, school correspondence, or multidisciplinary updates often requires precise tone, clarity, and pragmatics. AI-assisted drafting and tone refinement can reduce linguistic load while allowing the therapist to retain full control over content and boundaries. Clinically, these same features can be used to model appropriate email responses with older clients or adolescents working on functional communication and pragmatic skills. For psychologists and mental health professionals, the benefit lies in cognitive and emotional regulation. Difficult emails often trigger avoidance, anxiety, or overthinking. AI-supported drafting can help clients initiate responses, reduce rumination, and focus on the message rather than the stress of wording. In therapy, this opens space to discuss decision-making, boundaries, and reflective use rather than avoidance. For neurodivergent clients, particularly those with ADHD or ASD, Gemini may reduce barriers related to initiation, organisation, and interpretation of long email threads. Used intentionally, it can support access without masking needs. Used uncritically, it risks bypassing skill development. This distinction is where clinical guidance matters. There are also ethical considerations we cannot ignore. Gmail is not a clinical platform. Identifiable client information should never be entered into AI systems without safeguards. AI assistance does not remove professional responsibility for confidentiality, judgment, or relational nuance. The larger shift is this. AI is no longer a separate tool we choose to open. It is becoming part of the cognitive environment our clients live in. That means therapy cannot ignore it. Our role is not to resist these tools or to hand thinking over to them. Our role is to help clients and clinicians use AI reflectively, as support rather than authority. Three billion inboxes are about to change. Human judgment, clinical reasoning, and ethical care still need to lead.